E-Mail: redazione@bullet-network.com

- OpenAI ha raggiunto una precisione fino al 98% nel riconoscere immagini generate da DALL-E 3, ponendo le basi per un futuro digitale più sicuro.

- La sfida rimane nell'identificare contenuti generati da altre IA, con un tasso di successo che oscilla tra il 5% e il 10%.

- Previsto per il 2025, lo sviluppo di Media Manager mira a bilanciare innovazione tecnologica e rispetto dei diritti d'autore.

Nell’era dell’informazione digitale, la distinzione tra realtà e finzione diventa sempre più sfumata, soprattutto con l’avvento delle immagini generate dall’intelligenza artificiale (IA). OpenAI, pioniere nello sviluppo di tecnologie IA avanzate, ha recentemente annunciato lo sviluppo di nuovi strumenti progettati per identificare e tracciare i contenuti generati dall’IA, in particolare quelli prodotti da DALL-E 3. Questa mossa rappresenta un passo significativo nella lotta contro la disinformazione, mirando a stabilire con precisione se un’immagine sia stata generata artificialmente. Con una precisione dichiarata intorno al 98%, il classificatore di immagini di OpenAI segna un’evoluzione notevole nella capacità di discernere tra contenuti autentici e quelli fabbricati, anche se l’immagine è stata ritagliata, compressa o modificata nella saturazione. Tuttavia, è importante notare che l’efficacia dello strumento diminuisce drasticamente quando si tratta di identificare contenuti generati da altri programmi di IA, con un tasso di successo che oscilla tra il 5% e il 10%.

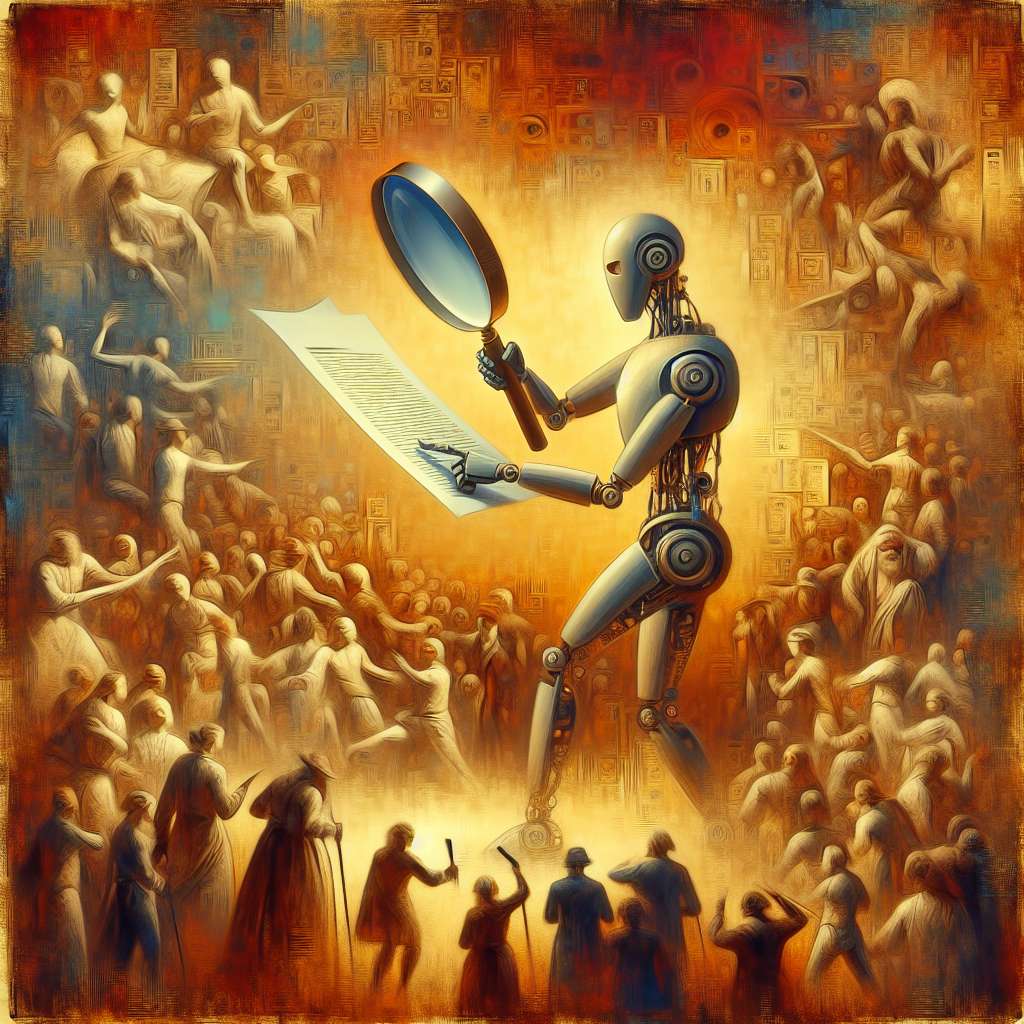

La Duplice Strategia di OpenAI: Classificazione e Watermarking

OpenAI non si limita alla sola identificazione delle immagini. L’organizzazione sta sviluppando metodi di watermarking, ovvero marcature digitali invisibili, per contrassegnare i contenuti audio generati dalla sua piattaforma di text-to-speech, Voice Engine. Questa strategia duplice, che combina la classificazione avanzata con il watermarking, mira a creare un ecosistema digitale più sicuro e trasparente. Inoltre, OpenAI ha aperto le iscrizioni per un programma di test rivolto a ricercatori e organizzazioni giornalistiche no-profit, sottolineando l’importanza della collaborazione nel contrastare la disinformazione. Nonostante i progressi, OpenAI riconosce le sfide che persistono, come dimostrato dall’abbandono di un programma simile nel 2023 a causa della scarsa affidabilità del classificatore.

Implicazioni e Sviluppi Futuri

L’annuncio di OpenAI non solo evidenzia i progressi tecnologici nella lotta contro la disinformazione ma solleva anche questioni importanti riguardanti la proprietà intellettuale e il diritto d’autore. OpenAI ha annunciato lo sviluppo di Media Manager, uno strumento che consentirà ai creatori di contenuti di gestire l’utilizzo delle loro opere per l’addestramento dell’IA generativa. Previsto per il 2025, questo strumento rappresenta un tentativo di bilanciare l’innovazione tecnologica con il rispetto dei diritti degli autori. Tuttavia, l’approccio di OpenAI allo sviluppo dell’IA, basato sullo scraping di dati, ha suscitato critiche e azioni legali, sottolineando la necessità di soluzioni più efficaci per proteggere i diritti d’autore nell’era dell’IA generativa.

Bullet Executive Summary

La lotta di OpenAI contro la disinformazione attraverso lo sviluppo di strumenti avanzati di identificazione e watermarking rappresenta un momento cruciale nel panorama dell’intelligenza artificiale moderna. Con una precisione fino al 98% nel riconoscimento di immagini generate da DALL-E 3, OpenAI pone le basi per un futuro digitale più sicuro e affidabile. Tuttavia, le sfide rimangono, soprattutto nell’identificare contenuti generati da altre IA e nel bilanciare l’innovazione con i diritti d’autore. Una nozione base di intelligenza artificiale correlata a questo tema è l’apprendimento automatico, che consente ai sistemi di migliorare la loro capacità di identificazione attraverso l’analisi di grandi quantità di dati. Un’area avanzata di ricerca, invece, riguarda lo sviluppo di algoritmi capaci di riconoscere sottili segni di manipolazione digitale, aprendo la strada a nuove frontiere nella verifica dell’autenticità dei contenuti. Questi sviluppi stimolano una riflessione personale sulla responsabilità condivisa nel promuovere un uso etico e consapevole dell’IA, per garantire un futuro digitale basato sulla verità e la trasparenza.