E-Mail: redazione@bullet-network.com

- Circa 37.000 palestinesi sono stati contrassegnati come sospetti militanti per possibili attacchi dall'IA Lavender.

- Il personale umano dedicava in media solo 20 secondi per la verifica dell'idoneità del bersaglio, portando a un elevato numero di errori.

- La decisione di utilizzare bombe non guidate ha aumentato il numero di vittime civili, con circa il 10% dei casi in cui venivano contrassegnati individui con legami deboli o inesistenti con gruppi militanti.

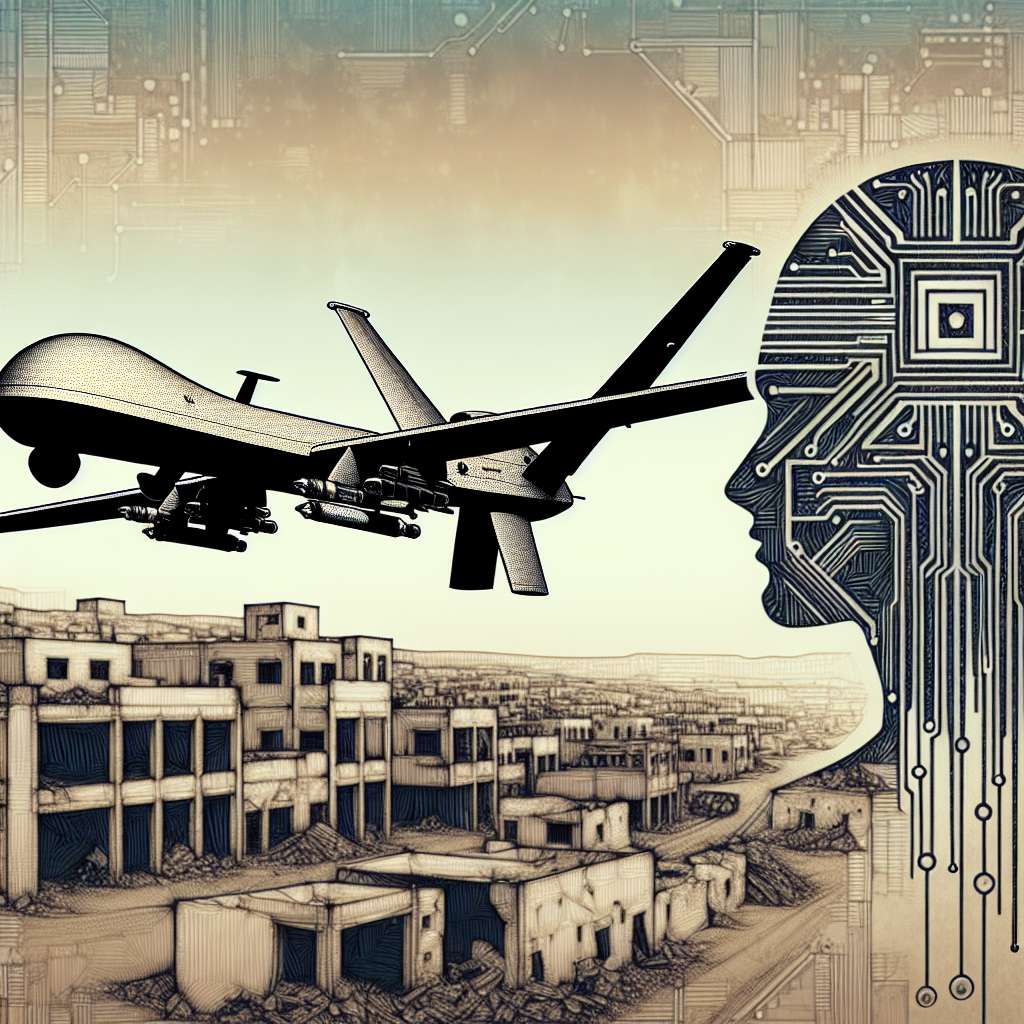

La guerra moderna è stata trasformata dall’avvento e dall’impiego dell’intelligenza artificiale (IA), con sistemi che possono identificare e designare obiettivi in tempo reale. Un esempio significativo di questa evoluzione è rappresentato dall’utilizzo del programma basato sull’IA, noto come Lavender, da parte dell’esercito israeliano durante l’Operazione “Iron Sword” nella Striscia di Gaza. Questo strumento ha segnato un punto di svolta nell’approccio alle operazioni militari, sollevando questioni etiche e legali riguardo al ruolo dell’IA nel teatro di guerra.

Il Ruolo di Lavender e Altri Sistemi AI

Lavender è stato sviluppato con lo scopo di individuare sospetti militanti di Hamas e della Jihad Islamica Palestinese, designandoli come potenziali obiettivi per attacchi aerei. Secondo le rivelazioni di un’inchiesta condotta da +972 Magazine e Local Call, circa 37.000 palestinesi sono stati contrassegnati come sospetti militanti per possibili attacchi. Questo sistema, insieme ad altri strumenti AI-based come Gospel e Where’s Daddy?, ha giocato un ruolo cruciale nelle operazioni militari, trattando le decisioni generate dall’IA quasi come se fossero state prese da esseri umani.

Implicazioni Etiche e Operative

L’impiego di Lavender e di sistemi simili solleva questioni significative riguardo alla delega di decisioni critiche a macchine. Una delle fonti intervistate ha rivelato che il personale umano spesso fungeva solo da “timbro di approvazione” per le decisioni prese dall’IA, dedicando in media solo “20 secondi” per la verifica dell’idoneità del bersaglio. Questa pratica ha portato a un elevato numero di “errori”, con circa il 10% dei casi in cui venivano contrassegnati individui con legami deboli o inesistenti con gruppi militanti.

Conseguenze Umanitarie

La dipendenza da sistemi automatizzati ha avuto conseguenze devastanti sul piano umanitario. L’approccio adottato dall’esercito israeliano, che ha incluso l’attacco a residenze familiari come prima opzione, ha portato alla morte di migliaia di palestinesi, molti dei quali donne e bambini o persone non coinvolte nei combattimenti. La decisione di utilizzare bombe non guidate, o “dumb bombs”, per colpire obiettivi di rango inferiore ha ulteriormente aumentato il numero di vittime civili.

Bullet Executive Summary

In conclusione, l’impiego dell’intelligenza artificiale in operazioni militari, come evidenziato dall’uso del sistema Lavender da parte dell’esercito israeliano, rappresenta una svolta significativa nella guerra moderna. La nozione base di intelligenza artificiale correlata a questo tema è la capacità dell’IA di analizzare enormi quantità di dati per identificare potenziali obiettivi. Tuttavia, una nozione avanzata di IA applicabile è la necessità di sviluppare sistemi che possano comprendere e applicare principi etici e legali, riducendo il rischio di danni collaterali e assicurando che le decisioni critiche rimangano sotto il controllo umano. Questo caso solleva interrogativi fondamentali sull’equilibrio tra efficacia operativa e responsabilità etica, stimolando una riflessione sulla direzione futura dell’impiego dell’IA in contesti bellici.